英国政府によるディープフェイク検出技術の標準化と日本経済への戦略的影響:包括的調査報告書

インフォグラフィック

スライド資料

英国のディープフェイク規制

解説動画

エグゼクティブ・サマリー

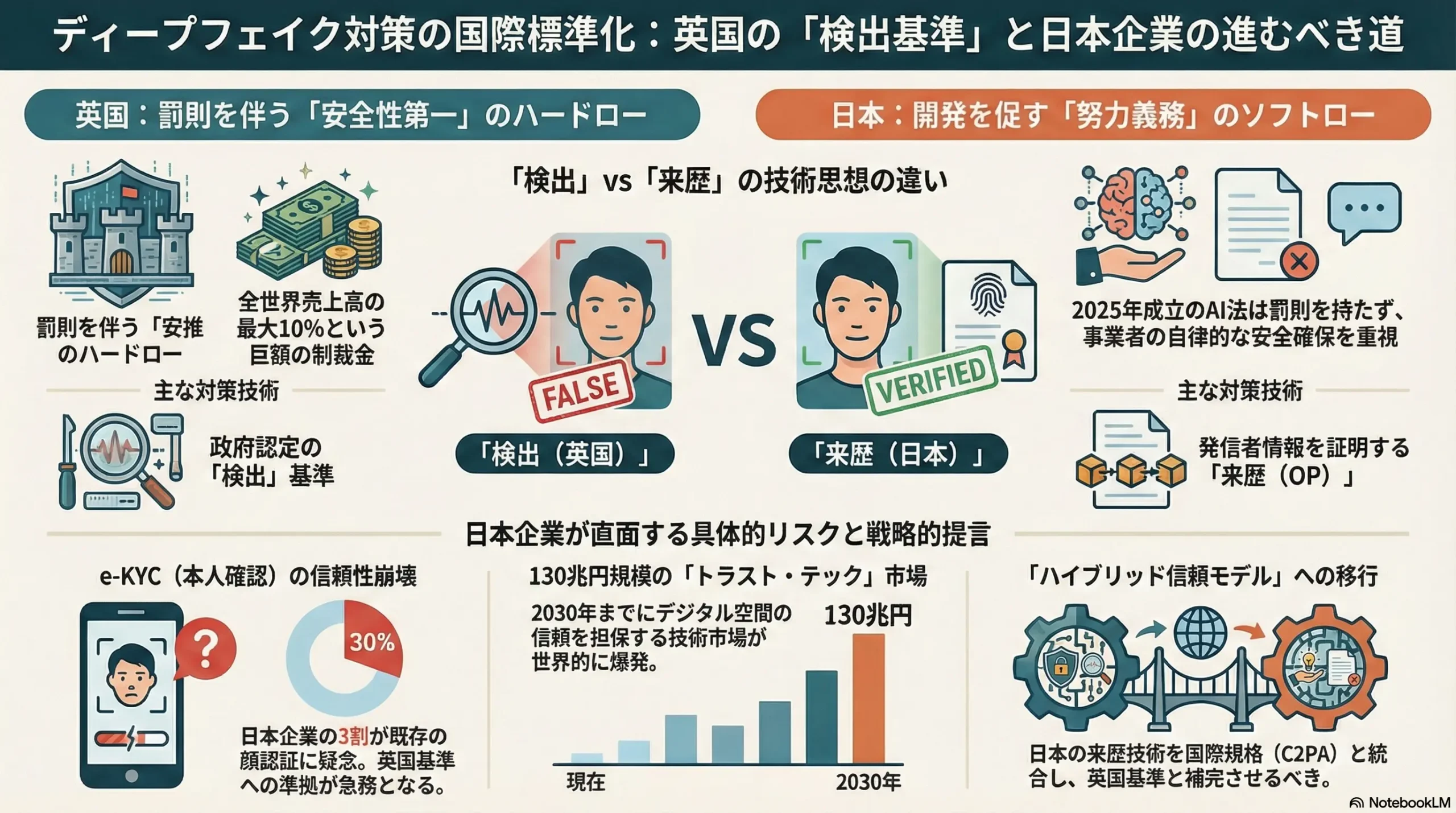

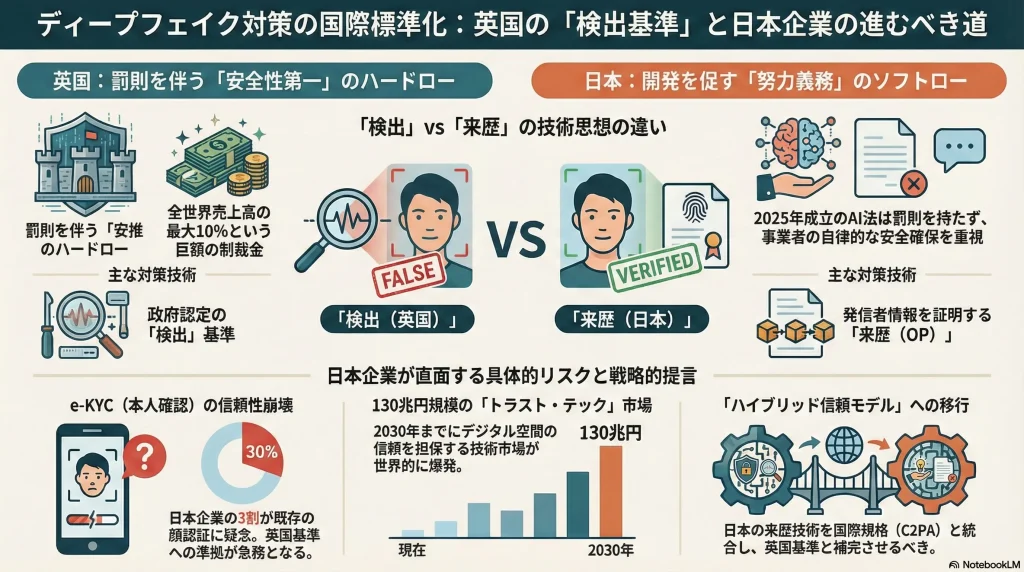

2026年2月5日、英国政府はマイクロソフトおよび主要な学術機関と連携し、世界初となる「ディープフェイク検出評価フレームワーク(Deepfake Detection Evaluation Framework)」の策定に着手したことを発表した1。この動きは、2023年の50万件から2025年には推定800万件へと爆発的に増加したAI生成の偽造コンテンツ(ディープフェイク)に対抗するため、従来の研究レベルの取り組みを産業界の統一基準へと昇華させる試みである3。

英国のこのイニシアチブは、単なる技術検証の枠を超え、AIガバナンスにおける「ルールの策定者」としての地位を確立しようとする地政学的な意思表示である。一方で、2025年5月に「AI関連技術の研究開発及び利用の促進に関する法律(AI法)」を成立させた日本は、「イノベーション第一」を掲げ、罰則を伴わないソフトロー路線を堅持している5。

本報告書では、英国の「ハードロー・検出重視」のアプローチと日本の「ソフトロー・来歴重視(Originator Profile)」のアプローチの間に生じつつある構造的な乖離を分析する。英国の新基準がデファクトスタンダード(事実上の標準)化することで、日本のデジタルプラットフォーム、金融機関(e-KYC依存)、およびコンテンツ産業が直面するコンプライアンスリスクと技術的負債を明らかにする。特に、日本のe-KYC市場においては、従来の顔認証技術が陳腐化し、2026年時点で30%以上の企業がその信頼性に疑念を抱き始めている現状7を踏まえ、英国基準への準拠が事実上の市場参入条件となる「外圧による強制アップデート」のシナリオを予測する。

1. 地政学的転換点:英国ディープフェイク検出フレームワークの全貌

1.1 「受動的監視」から「能動的標準化」へのパラダイムシフト

英国政府の発表は、ディープフェイク対策が「個別の企業努力」から「国家主導の標準化」へとフェーズを移行させたことを意味する。DSITと内務省(Home Office)が主導するこのフレームワークは、AI生成コンテンツの検出ツールに対して、一貫した評価基準を設定する世界初の試みである1。

これまで、ディープフェイク検出技術は各セキュリティベンダーが独自の指標で精度を競っていたが、統一されたベンチマークが存在しなかったため、導入企業はその有効性を客観的に判断することが困難であった。英国政府は、マイクロソフトやアラン・チューリング研究所などの専門機関と連携し、実際の脅威(詐欺、性的虐待、なりすまし)に基づいたデータセットを用いてツールをテストするアーキテクチャを構築する1。これにより、英国市場で流通する検出ツールには、一定の「安全性認証」が付与される形となり、事実上の参入障壁として機能することになる。

1.2 標的となる脅威と技術的スコープ

このフレームワークが特に対象としているのは、以下の3つの高リスク領域である2。

- 非合意の性的画像(NCII): 英国では、2025年のデータ(使用とアクセス)法およびオンライン安全法(Online Safety Act)により、性的ディープフェイクの作成およびその作成ツールの提供が刑事罰の対象となっている4。新フレームワークは、これらのコンテンツをプラットフォーム上で「未然に」検出する能力を厳格に評価する。

- 金融詐欺とCEOなりすまし: 企業の幹部になりすまして資金移動を指示するビジネスメール詐欺(BEC)の動画版に対し、リアルタイムでの検出能力が求められる。

- 民主主義への介入: 選挙期間中の政治的偽情報の拡散防止。

特筆すべきは、この基準が「生成元がどこであるかを問わず(no matter where they come from)」適用される点である1。これは、日本を含む海外のAI企業が開発した生成ツールや、それによって作成されたコンテンツであっても、英国のデジタル空間に入る限りはこの検出基準の対象となることを示唆している。

1.3 マイクロソフトとの連携が示す「官民一体の覇権」

英国政府がパートナーとしてマイクロソフトを選定したことは、単なる技術協力以上の意味を持つ1。マイクロソフトはOpenAIへの主要出資者であり、生成AIの基盤モデルに深い知見を持つ。攻撃側(生成AI)の論理を知るプレイヤーを防衛側(検出基準)の策定に組み込むことで、英国は技術的に極めて高度、かつ実効性の高い基準を作り上げようとしている。

これは、日本がG7広島サミット(広島AIプロセス)で主導しようとした「国際的な行動規範」というソフトな合意形成12に対し、英国がより具体的で実装可能な「技術標準(テクニカル・スタンダード)」を提示することで、AIガバナンスの実務的な主導権を握ろうとする動きと解釈できる。

2. 規制の非対称性:英国「ハードロー」対 日本「ソフトロー」

英国の新フレームワークの登場により、日英間の規制環境の乖離(レギュラトリー・ギャップ)が鮮明になった。このギャップは、グローバルに展開する日本企業にとって深刻な経営リスクとなる。

2.1 英国:罰則付きの「義務化」された安全性

英国のAIガバナンスは、2023年オンライン安全法(Online Safety Act: OSA)を法的根拠とし、極めて強力な執行力を持っている。

- 高額な制裁金: OSAに基づき、違法コンテンツ(ディープフェイクを含む)のリスク評価や排除を怠ったプラットフォーム企業には、最大で1,800万ポンドまたは全世界売上高の10%のいずれか高い方の罰金が科される14。

- 刑事罰の適用: 性的ディープフェイクの作成者はもとより、それを可能にするツール(nudification tools)の提供者も刑事罰の対象となる4。

- 域外適用: 英国に物理的な拠点がなくとも、英国内のユーザーにサービスを提供している限り、日本企業もこの規制の対象となる。実際に、米国の画像掲示板「4chan」などがOfcom(英国通信庁)から警告を受けている事例がある14。

英国政府が策定する「検出評価フレームワーク」は、これらの法的義務を遵守するための「ゴールドスタンダード」として機能する可能性が高い。つまり、企業が「十分な対策を講じた」と証明するためには、このフレームワークで認定された技術を導入せざるを得なくなる構造である。

2.2 日本:イノベーション優先の「努力義務」

対照的に、日本のAI規制は「イノベーション・ファースト」を掲げ、事業者への過度な負担を避ける設計となっている。

- 2025年AI法(AI関連技術の研究開発及び利用の促進に関する法律): 2025年5月に成立したこの法律は、AI開発者や提供者に対し「安全性の確保に努める」という努力義務(doryoku-gimu)を課すにとどまり、罰則規定は存在しない5。

- ソフトロー中心のアプローチ: 経済産業省や総務省が策定した「AI事業者ガイドライン」は詳細であるが、法的拘束力を持たない。違反した場合の制裁は、主務大臣による勧告や公表(ネーミング・アンド・シェイミング)に限られる5。

- ディープフェイクへの法的対応: 日本にはディープフェイクの作成自体を直接処罰する包括的な法律は存在しない。名誉毀損、業務妨害、著作権法といった既存の法枠組みを適用して対処しているのが現状である5。

2.3 構造的な「コンプライアンス・ギャップ」の発生

以下の表は、日英の規制環境の違いが日本企業に及ぼす具体的な影響を比較したものである。

| 比較項目 | 英国(2026年体制) | 日本(2025年体制) | 日本企業への影響・リスク |

|---|---|---|---|

| 基本哲学 | 安全性・害悪排除(Safety First) | 研究開発・利用促進(Innovation First) | 日本国内で適法なサービスが英国で違法となるリスク。 |

| ディープフェイク規制 | 作成・拡散・ツール提供を刑事罰化 | 名誉毀損等による民事・事後対応が主 | 英国展開時に高リスク。ツールの仕様変更が必要。 |

| 検出技術の要件 | 政府認定フレームワーク準拠が事実上必須 | 事業者の自律的な判断に委ねられる | 英国市場向けに高コストな検出技術の導入が必要。 |

| 違反時のペナルティ | 全世界売上高の10%の罰金、サイトブロッキング | 行政指導、企業名公表 | 経営基盤を揺るがす財務リスクの非対称性。 |

表1: AIガバナンスにおける日英規制モデルの比較分析 4

この非対称性は、日本企業がグローバル市場で競争する際、「日本基準(低コスト・低規制)」と「英・EU基準(高コスト・高規制)」の二重投資(ダブルスタンダード対応)を強いられることを意味する。特に、英国の検出基準が「世界のデファクト」となった場合、日本の緩やかな基準に合わせて開発された製品は、国際市場から「信頼性が低い(Unsafe)」として排除される恐れがある。

3. デジタル「本人確認」崩壊の危機:日本の金融・通信産業への衝撃

英国が検出技術の標準化を急ぐ背景には、生成AIによる「なりすまし」が既存のセキュリティインフラを無力化しつつあるという危機感がある。この波は、e-KYC(電子的本人確認)に大きく依存し始めた日本の産業界にも直撃している。

3.1 顔認証e-KYCの陳腐化と「信頼の崩壊」

日本のフィンテックおよび通信業界では、非対面での口座開設や契約において、スマートフォンで顔写真と本人確認書類を撮影する「顔認証e-KYC」が急速に普及した。Liquid社やPolarify社などが提供するソリューションは、ゆうちょ銀行、ソフトバンク、楽天モバイルなど主要インフラで採用されている16。

しかし、2026年現在、この前提は崩れつつある。

- 技術的脅威: 生成AIの進化により、瞬きや顔の微細な動き、照明の反射までもリアルタイムで模倣する「プレゼンテーション攻撃」が可能になった。2025年時点で、ディープフェイク動画を用いた詐欺は前年比で数千パーセントの増加を見せている地域もある17。

- 市場の反応: 調査によれば、日本企業の約3割が、もはや顔認証単独での本人確認を信頼できないと判断し始めている7。経営層の98%以上が「ディープフェイクを見分ける自信がない」と回答しており、システムへの信頼は危機的状況にある。

英国の新基準は、このような状況に対し「どのような検出技術であれば信頼できるか」という答えを提示するものである。日本のe-KYCベンダーは、英国基準(マイクロソフト等が検証した高レベルなLiveness Detectionなど)に準拠した技術へのアップデートを迫られることになる。これに対応できない場合、日本の金融機関は国際的な送金ネットワークや提携から「セキュリティホール」として敬遠されるリスクがある。

3.2 「採用面接詐欺」と企業セキュリティの脆弱化

日本では、人材不足を背景にウェブ面接が定着しているが、ここにもディープフェイクの影が落ちている。

- 採用詐欺の手口: 候補者が生成AIを使用して外見や声を偽装し、別人の経歴で面接を通過する事例が増加している。特にITエンジニアの採用において、技術スキルを持つ別人がリアルタイムで回答を代行し、入社後に低スキルの人物(あるいは悪意あるアクター)が内部システムにアクセスするという「トロイの木馬」的な攻撃が懸念されている7。

- 対策の遅れ: 英国のフレームワークは、ビデオ会議ツールにおけるリアルタイム検出もスコープに入れている。日本企業の人事部門は、今後「Zoom」や「Teams」などのツールに対し、英国基準に準拠した検出プラグインの導入を必須要件とするようになるだろう。

3.3 CEOなりすまし詐欺(Deepfake Business Video Compromise)

従来のビジネスメール詐欺(BEC)は、ディープフェイクを用いた「ビジネスビデオ詐欺」へと進化した。2025年、アジア太平洋地域でのディープフェイク詐欺増加率はベトナムに次いで日本が23.4%増と高く、標的となっている17。 英国の取り組みは、このような金融犯罪に使用されるディープフェイクの検出を「国家安全保障」レベルの優先事項としている。日本の銀行業界も、英国の基準を参照し、高額送金時の承認プロセスにAIによる動画解析(不自然な音声波形や画像の継ぎ目の検出)を組み込むことが不可避となる。

4. 技術思想の衝突:英国「検出(Detection)」対 日本「来歴(Provenance)」

本調査における最も重要な洞察の一つは、ディープフェイク問題に対する解決アプローチにおいて、日英で根本的な「技術思想の対立」が存在することである。

4.1 英国のアプローチ:検出(Detection)=「免疫システム」

英国の戦略は、「悪意あるコンテンツは必ず発生する」という前提に立ち、それを事後的に発見・隔離する「検出技術」の高度化に資源を集中している1。

- メリット: コンテンツ作成者の協力が不要。海外からの攻撃や匿名掲示板など、コントロール不可能な領域にも適用可能。

- デメリット: 「いたちごっこ」である点。AIセキュリティ企業のImmuniWebのCEOが指摘するように、検出AIが進化すれば、生成AIもそれを回避するように学習するため、恒久的な解決にはならない2。

4.2 日本のアプローチ:来歴管理(Originator Profile)=「デジタル・パスポート」

対照的に、日本は「偽物を探す」のではなく「本物を証明する」アプローチに注力している。朝日新聞やNTTなどが主導する「Originator Profile (OP)」技術は、ウェブコンテンツの発信者情報を電子署名で検証可能にするものである18。

- コンセプト: コンテンツに「デジタル透かし」やメタデータを埋め込み、ブラウザ上で「誰が発信したか」を確認できるようにする。

- メリット: 技術的な「いたちごっこ」を回避できる。信頼できる発信元(メディア、政府、企業)からの情報を確実に識別できる。

- デメリット: 全世界的な普及(エコシステムの構築)が必要。匿名表現の自由との兼ね合いや、プライバシー懸念がある20。

4.3 「ガラパゴス化」のリスクと統合への道

英国が検出技術の国際標準化に乗り出したことで、日本のOP技術は岐路に立たされている。もし世界が「検出ツールによるフィルタリング」を標準とした場合、日本独自の「来歴証明」は、海外プラットフォーム(X, Instagram, YouTube)で無視される「ガラパゴス規格」になる恐れがある。

- C2PAとの統合: 日本の生き残る道は、OP技術を欧米主導の標準規格である「C2PA(Coalition for Content Provenance and Authenticity)」と完全に相互運用可能にすることである21。英国の検出フレームワークが「C2PAのメタデータを持つコンテンツは信頼スコアを上げる」といった形で統合されれば、日本の技術もグローバルサプライチェーンに組み込まれる余地がある。

- 戦略的提言: 日本政府および産業界は、英国の検出フレームワークに対抗するのではなく、それを補完する技術としてOPを位置づけ、G7等の場で「検出(英国)+来歴(日本)=完全な信頼」というナラティブを構築すべきである。

5. 経済的影響予測:2026年-2030年の市場変容

英国発の規制トレンドは、日本の経済活動に具体的なコスト増と新たな市場機会をもたらす。

5.1 「トラスト・テック(Trust Tech)」市場の爆発的成長

デジタル空間での信頼を担保する「トラスト・テック」市場は、2030年までに世界で9,099億ドル(約130兆円)規模に達すると予測されている23。日本市場も年平均成長率(CAGR)13.1%で拡大が見込まれる。

- 需要のシフト: 英国基準の波及により、単なる「顔認証」から、生体反応検知(フラッシュ判定、表情筋解析)や、デバイスの所有者認証(FIDO等)を組み合わせた「マルチモーダル認証」への投資が急増する。NECやLiquidといった国内ベンダーにとっては、英国基準に適合した次世代製品を開発できれば、大きな輸出機会となる。

5.2 デジタルプラットフォームのコンプライアンスコスト増大

英国市場に進出している、あるいは英国ユーザーを持つ日本のプラットフォーム企業(ゲーム会社、VTuber事務所、SNSアプリ等)は、以下のコスト増に直面する。

- ハッシュマッチング技術の導入: 英国Ofcomは、既知の違法ディープフェイク(特に性的画像)を投稿前に検知・削除する「ハッシュマッチング」の導入を検討している14。日本企業もこのデータベースへのアクセス権購入とシステム改修が必要になる。

- リスク評価の義務化: 年次での詳細なリスク評価と、それに基づく安全対策(年齢確認の厳格化など)が求められ、法務・コンプライアンス部門の人員増強が不可欠となる。

5.3 コンテンツ産業(アニメ・マンガ)への「ナディフィケーション」規制の余波

英国が「ナディフィケーション(着衣画像を裸体化するAIツール)」を明確に禁止し、刑事罰化したこと1は、日本のコンテンツ産業にとってグレーゾーンのリスクを生む。

- 二次創作とAI: 日本の同人文化やファンコミュニティにおいて、AIを用いた画像生成が普及しているが、実在の人物(アイドルや声優)や、実写に近いリアリズムを持つキャラクターを対象とした生成物が、英国法の下では「違法な性的ディープフェイク」と認定されるリスクがある。

- 輸出規制の可能性: 日本で開発された画像生成AIソフトやアプリが、英国市場で「ナディフィケーションツール」として認定されれば、アプリストアからの削除や法的制裁を受ける可能性がある。開発企業は、英国基準に準拠したフィルタリング機能(セーフティガード)の実装を迫られる。

6. 日本産業界への戦略的提言:受動的対応から能動的適応へ

英国の動きを「対岸の火事」と捉えず、デジタル社会の新たなOS(基本ソフト)のアップデートと捉え、官民が連携して対応策を講じる必要がある。

6.1 政府・規制当局(経産省・金融庁)への提言

- 「日本版検出基準」の早期策定: 英国のフレームワークを詳細に分析し、整合性のある日本国内向けの検出評価基準を策定すべきである。独自基準に固執せず、英国(および米国NIST)との相互認証を目指すことで、日本企業の二重投資を防ぐ。

- ソフトローの限界を見極める: 2025年AI法のアプローチ(イノベーション重視)は維持しつつも、ディープフェイクによる詐欺や権利侵害に関しては、既存法(名誉毀損等)の解釈拡大ではなく、より明確な禁止規定や、悪質なツール提供者への罰則を含む法改正の検討が必要になる可能性がある。

- OP技術の国際標準化支援: Originator Profile技術が「ガラパゴス」にならないよう、C2PAや世界経済フォーラム(WEF)の枠組みを通じて、国際的な認知獲得と技術連携を強力に推進する。

6.2 金融・インフラ企業への提言

- 「防御の深層化(Defense in Depth)」: e-KYCにおいて、顔認証のみに依存する体制を脱却する。公的個人認証(JPKI)の活用や、スマホのセキュアエレメントを用いた認証(FIDO)など、AIによる偽造が困難な物理的・暗号学的認証を併用する「多要素認証」を標準とする20。

- CIBA(Client Initiated Backchannel Authentication)の導入: 電話やビデオ通話での指示(CEO詐欺リスク)に対し、登録済みデバイスへプッシュ通知を送り、生体認証で承認させるCIBAの仕組みを導入することで、映像や音声が偽物であっても、取引を阻止できる仕組みを構築する20。

6.3 AI開発・コンテンツ企業への提言

- 「Watermarking by Design(設計段階からの透かし)」: 英国やEUの規制を見据え、生成される全てのコンテンツにC2PA準拠の来歴情報を自動埋め込みする機能を標準実装する。これが将来的な「市場参入パスポート」となる。

- デュアル・トラック戦略: 国内向けの柔軟な開発体制と、英・EU向けの厳格なコンプライアンス体制を分ける「デュアル・トラック(二線級)」戦略を採用し、イノベーションの速度を落とさずにグローバルリスクを管理する6。

7. 結論:真実の標準化競争における日本の立ち位置

英国政府による2026年2月の発表は、デジタル空間における「真実」を誰が定義し、どのように守るかという国際的な競争の号砲である。英国は「検出技術の標準化」を通じて、AI時代の信頼インフラの管理者となろうとしている。

日本にとって、この動きは「外圧」であると同時に「機会」でもある。日本のe-KYC市場やコンテンツ産業は、ディープフェイクという「見えない敵」によって信頼の基盤を侵食されつつある7。英国の厳格な基準は、脆弱化した日本のデジタル認証システムを強制的にアップデートする契機となり得る。

「イノベーション・ファースト」を掲げる日本であるが、信頼(Trust)なきイノベーションは持続不可能である。英国が先行する「検出(Detection)」技術と、日本が育んできた「来歴(Provenance)」技術を融合させ、ハイブリッドな信頼モデルを構築できるかどうかが、2030年に向けた日本のデジタル経済の勝敗を分かつことになるだろう。日本企業は、英国の基準を単なるコスト増と捉えるのではなく、次世代の「トラスト・テック」市場で勝ち残るための必須教養として取り込むべきである。

引用文献

- Government Leads Global Fight Against Deepfake Threats | Financial IT, https://financialit.net/news/cybersecurity/government-leads-global-fight-against-deepfake-threats

- British Government To Develop A Deepfake Detection Framework, https://www.cybersecurityintelligence.com/blog/british-governmentto-develop-a-deepfake-detection-framework-9096.html

- UK’s deepfake detection plan unlikely to work, says expert • The …, https://www.theregister.com/2026/02/05/uk_government_deepfake_framework/

- Government leads global fight against deepfake threats, https://www.gov.uk/government/news/government-leads-global-fight-against-deepfake-threats

- AI Watch: Global regulatory tracker – Japan | White & Case LLP, https://www.whitecase.com/insight-our-thinking/ai-watch-global-regulatory-tracker-japan

- Japans New AI Act Examining an InnovationFirst Approach Against …, https://www.twobirds.com/en/insights/2025/japan/japans-new-ai-act-examining-an-innovationfirst-approach-against-the-eus-comprehensive-risk-framework

- 2026年、ディープフェイクはどこまで進化したのか?AI …, https://ai.reinforz.co.jp/76

- UK picks Microsoft to help develop deepfake detection system, https://www.computing.co.uk/news/2026/government/uk-picks-microsoft-to-help-develop-deepfake-detection-system

- New UK deepfake detection testing framework, challenge aim to …, https://www.biometricupdate.com/202602/new-uk-deepfake-detection-testing-framework-challenge-aim-to-meet-crisis-head-on

- When AI impersonates – taking action against deepfakes in the UK – Mishcon de Reya, https://www.mishcon.com/news/when-ai-impersonates-taking-action-against-deepfakes-in-the-uk

- ディープ・フェイク検出へ基準作成―世界初、マイクロソフトと連携 – – ドイツニュースダイジェスト, http://www.newsdigest.de/news/news/uk-news/26956-2026-02-07.html

- Diverging paths to AI governance: how the Hiroshima AI Process offers common ground, https://www.weforum.org/stories/2025/12/hiroshima-ai-process-governance/

- The Hiroshima AI Process: Leading the Global Challenge to Shape Inclusive Governance for Generative AI – JapanGov, https://www.japan.go.jp/kizuna/2024/02/hiroshima_ai_process.html

- UK – The Online Safety Act 2023 – the landscape two years on, https://www.linklaters.com/en/insights/blogs/digilinks/2025/september/uk-the-online-safety-act-2023-the-landscape-two-years-on

- Grok, generative AI and the UK Online Safety Act, https://www.simmons-simmons.com/en/publications/cmkfjc1xl0030v4tklthq0jn3/grok-generative-ai-and-the-uk-online-safety-act

- 大手サービスのeKYCの導入事例を調査, https://www.ekyc-guide.com/scene/case-study.html

- Rogue replicants: Criminal exploitation of deepfakes in South East Asia | Global Initiative, https://globalinitiative.net/analysis/deepfakes-ai-cyber-scam-south-east-asia-organized-crime/

- TPAC 2024: Breakouts schedule – W3C, https://www.w3.org/2024/09/TPAC/breakouts.html

- Summer 2024 NEXT Alliance Study Trip, summary by James L …, https://spfusa.org/wp-content/uploads/2024/10/For-Pub-NAJST24-Summary-Report.pdf

- Deepfake Damages Worth $40 billion? — The Impact of Generative …, https://nat.sakimura.org/2024/08/25/2004/

- Detecting deepfakes and Generative AI: Standards for AI watermarking and multimedia authenticity – AI for Good, https://aiforgood.itu.int/event/detecting-deepfakes-and-generative-ai-standards-for-ai-watermarking-and-multimedia-authenticity/

- Policy paper: Building trust in multimedia authenticity through …, https://s41721.pcdn.co/wp-content/uploads/2021/10/AMAS-Policy-Paper-Building-Trust-in-Multimedia-Authenticity-through-International-Standards-Web-V5.pdf

- Digital Trust – デジタル・トラストの世界市場, https://www.gii.co.jp/report/go1745068-digital-trust.html